L’intelligence artificielle ou IA est devenue l’un des concepts les plus en vogue au XXIᵉ siècle. Même si le terme « intelligence artificielle » semble cool, ce ne sont que des algorithmes et des probabilités qui se cachent derrière.

Du point de vue théorique, l’intelligence artificielle n’a rien de nouveau. Les premières réflexions concernant les réseaux neuronaux datent de 1940. Toutefois, grâce aux dernières avancées en matière de puissance de calcul, la théorie est devenue réalité.

Mais, pourquoi l’intelligence artificielle fait-elle l’objet d’un tel engouement ? L’IA va-t-elle prendre le contrôle de notre vie ? Comment fonctionne l’IA ? Quels types d’IA existe-t-il ? Quels sont les avantages et les inconvénients de l’intelligence artificielle?

Voici un exposé exhaustif de ce qu’est l’intelligence artificielle. Après avoir lu ce guide, vous comprendrez mieux pourquoi l’IA est essentielle pour les humains. Plus important encore, vous comprenez ce que signifie l’intelligence artificielle et comment elle fonctionne. Vous apprendrez également quels sont les types d’IA existants et quelles sont les principales utilisations de l’IA.

Qu’est-ce que l’intelligence artificielle (IA) ?

L’intelligence artificielle ou IA simule le processus de pensée humain par un ordinateur ou d’autres machines. L’objectif de l’IA est de créer des programmes informatiques capables de reproduire les capacités de résolution de problèmes et de prises de décision que possèdent les humains.

Sous le capot, l’IA est un terme fantaisiste pour désigner l’utilisation de l’algèbre linéaire pour analyser des données et faire des prédictions.

La principale caractéristique de l’Intelligence Artificielle est que les programmes peuvent apprendre à partir de données étiquetées. Lorsque l’IA reçoit une entrée, elle fait une prédiction établie à partir des données qu’elle a analysées dans le passé.

Au cours des deux dernières années, l’utilisation de l’IA a augmenté rapidement. Cela a engendré des applications impressionnantes, telles que:

-

Les voitures à conduite autonome,

-

Les systèmes de reconnaissance faciale,

-

Eh bien plus encore

Contrairement à ce que l’on pourrait croire, l’intelligence artificielle n’est pas aussi mythique et magique qu’il n’y paraît. Avant de plonger plus profondément pour comprendre le fonctionnement de l’IA, voyons un exemple de programme d’IA.

Exemple de programme d’intelligence artificielle

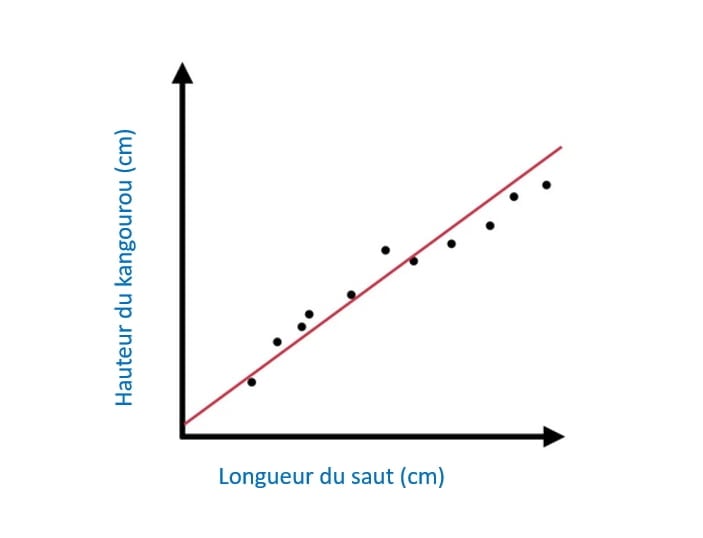

Un exemple simple de programme d’IA est un modèle qui prédit la distance à laquelle un kangourou peut sauter compte tenu de sa taille. Pour utiliser ce programme, il faut :

- Mesurer la hauteur d’un groupe de kangourous.

- Mesurer la longueur des sauts des kangourous.

- Utiliser l’algèbre linéaire pour trouver la corrélation entre la hauteur du kangourou et la longueur du saut.

Mathématiquement parlant, la dernière étape consiste à trouver la pente d’un graphique dans un plan x-y. Il s’agit ici de la première phase d’apprentissage du programme.

Une fois les données analysées par le programme, ce dernier peut prendre la taille d’un kangourou en entrée et calculer la longueur du saut en sortie.

Le programme ci-dessus est un exemple d’apprentissage automatique, qui est un sous-domaine de l’IA. Pour construire ce type de programme, vous devez posséder des compétences de base en programmation et quelques notions de mathématiques de niveau secondaire.

Bien sûr, sur la base de cette description, vous ne pouvez pas simplement aller mettre en œuvre un tel programme. Mais, je voulais vous exposer cela pour vous démontrer que l’IA n’est vraiment rien d’autre que des mathématiques en arrière-plan.

Comprendre l’intelligence artificielle

La grande majorité des personnes pensent aux robots lorsqu’ils entendent le terme « intelligence artificielle ». C’est parce que les films et les romans sont remplis d’histoire où les robots IA ont conquis le monde.

C’est loin d’être le cas!

L’IA n’est rien d’autre qu’un programme informatique mathématique qui traite et analyse des données.

Le concept d’IA repose sur l’idée qu’un ordinateur peut facilement imiter le processus d’intelligence humaine. Cela va de tâches simples à des tâches plus complexes.

Plus tôt, vous avez vu un exemple de prédiction du saut d’un kangourou en fonction de sa hauteur. Il s’agit d’un programme d’IA simple, relativement facile à créer.

Il existe des tâches beaucoup plus complexes que l’IA pourrait être capable d’accomplir.

Récemment, des développeurs et des chercheurs en IA ont été capables d’imiter les activités du cerveau humain, par exemple :

-

L’apprentissage

-

Le raisonnement

-

La perception

En réalité, il est déjà possible de définir concrètement ces activités.

En raison de l’évolution rapide de l’IA, de nombreux experts pensent que, dans un avenir proche, l’homme pourra développer une IA qui dépassera les capacités du cerveau humain.

Comme toute activité cognitive repose sur des jugements de valeur et est hautement subjective, d’autres pensent que l’IA ne dépassera jamais les humains.

Seul le temps nous dira si cela est vrai ou non.

L’IA étant un concept large, elle a été divisée en une multitude de sous-domaines ou types d’IA. Voyons maintenant les sous-domaines les plus importants de l’IA, dont certains vous sont peut-être familiers.

Les sous domaines de l’intelligence Artificielle

L’intelligence artificielle est un concept vaste. Tout comme le cerveau humain possède de multiples fonctions, l’IA comporte de nombreux sous-domaines et études.

Les principaux types de l’IA sont les suivants:

- Apprentissage automatique (machine Learning)

- Apprentissage profond (Deep Learning)

- Réseau neuronal (Neural Network)

- Informatique cognitive

- Traitement du langage naturel (TLN)

- Vision par ordinateur

Il est fort probable que vous ayez déjà entendu au moins quelques-uns de ces termes. Comme pour l’IA, les noms des sous-domaines de l’IA sont souvent utilisés.

Notez que les frontières entre ces branches d’intelligence artificielle ne sont pas claires.

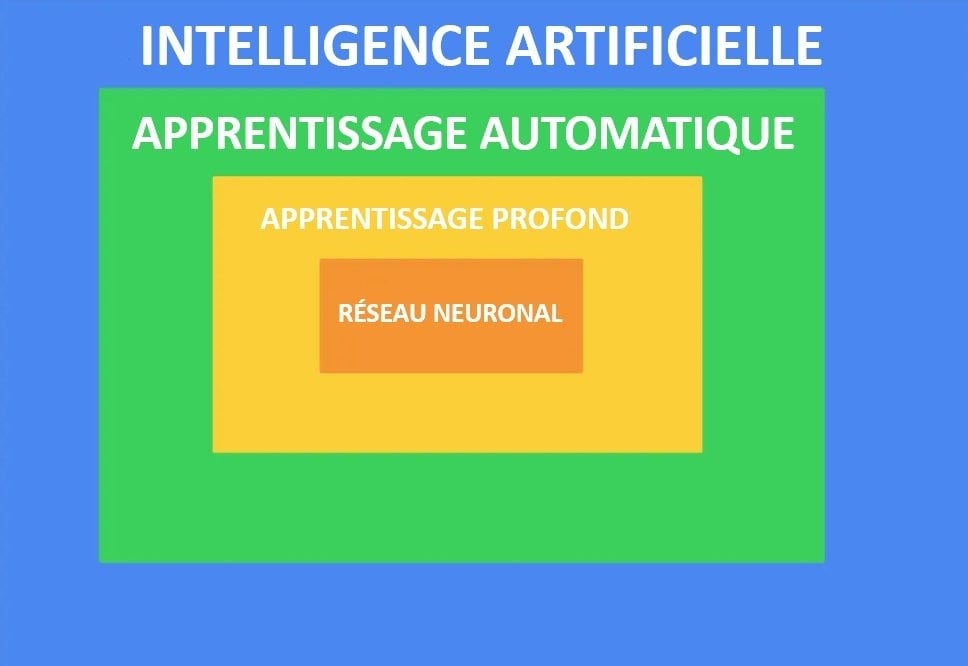

Avant d’entrer dans les détails de ces branches de l’IA, jetez un coup d’œil à l’image ci-dessous. Cette image illustre la relation entre l’IA, l’apprentissage automatique, les réseaux neuronaux et l’apprentissage profond :

Comme vous pouvez le constater, l’IA est l’organe directeur de l’apprentissage automatique, qui régit l’apprentissage profond, qui régit les réseaux neuronaux.

Examinons maintenant de plus près ces types de l’IA.

1. L’apprentissage automatique (Machine learning)

L’apprentissage automatique, ou encore l’apprentissage machine (Machine Learning, ML) est une branche populaire de l’intelligence artificielle. Ce domaine d’étude se concentre sur l’utilisation de données et d’algorithmes pour imiter le processus d’apprentissage humain.

Les programmes d’apprentissage automatique apprennent à partir de données et la précision des programmes s’améliore progressivement.

L’exemple de la longueur du saut du kangourou est une parfaite démonstration de l’apprentissage automatique. Le programme informatique est capable de comprendre comment la taille du kangourou affecte la longueur de son saut.

Comment fonctionne le machine learning ?

D’une manière générale, le processus d’apprentissage automatique commence par l’observation et la collecte de données. Ces observations peuvent être n’importe quoi, par exemple :

-

Des exemples

-

Des expériences concrètes

-

Des instructions

Les algorithmes d’apprentissage automatique commencent à rechercher des modèles dans ces données. Plus tard, le programme d’apprentissage machine peut utiliser les données et les modèles pour faire des déductions.

La fonction clé de tout programme d’apprentissage machine est d’automatiser le processus d’apprentissage informatique. Un programme d’apprentissage automatique efficace peut apprendre à partir de données sans intervention ni assistance humaine. En outre, il peut effectuer des actions établies sur les apprentissages.

Le concept d’apprentissage automatique existe depuis un certain temps déjà. Le terme a été inventé par Arthur Samuel, un informaticien d’IBM. Arthur a créé un programme d’IA capable de jouer aux échecs.

Arthur a conçu le programme pour apprendre à partir des jeux précédents. Ainsi, plus le programme jouait, plus il acquérait d’expérience et plus, il s’améliorait.

Il s’agissait de la première application de l’apprentissage machine tel que nous le connaissons.

L’apprentissage automatique est un concept important et un sous-domaine de l’IA. Un programme d’apprentissage machine peut résoudre des problèmes beaucoup plus rapidement qu’un humain ne le pourrait.

Grâce à la puissance de calcul des ordinateurs modernes, les machines peuvent facilement identifier des modèles dans les données d’entrée pour automatiser les processus manuels.

Même si l’apprentissage automatique est un sous-domaine de l’IA, il s’agit d’un concept très vaste. Pour qu’un programme informatique apprenne, il existe de nombreuses stratégies parmi lesquelles choisir. Les méthodes d’apprentissage machine les plus populaires sont les suivantes :

-

Apprentissage supervisé

-

Apprentissage non supervisé

-

Apprentissage semi-supervisé

Pour ne pas sortir du cadre, nous n’allons pas nous y attarder!

Même si l’apprentissage automatique semble être une fiction, ce n’est pas le cas. L’apprentissage automatique est utilisé dans les entreprises du monde entier dans différents secteurs.

Voici quelques-unes des technologies et des industries notables qui utilisent l’apprentissage automatique pour améliorer leurs produits :

Examinons maintenant une autre branche de l’apprentissage automatique appelé apprentissage profond.

2. Apprentissage profond (Deep Learning)

L’apprentissage par le biais de l’exemple est un processus naturel pour nous, les humains. À l’encontre, un ordinateur ne comprend pas ce qu’est l’apprentissage.

L’apprentissage profond est un sous-domaine de l’apprentissage automatique. Les algorithmes d’apprentissage profond enseignent aux ordinateurs comment apprendre à partir d’exemples.

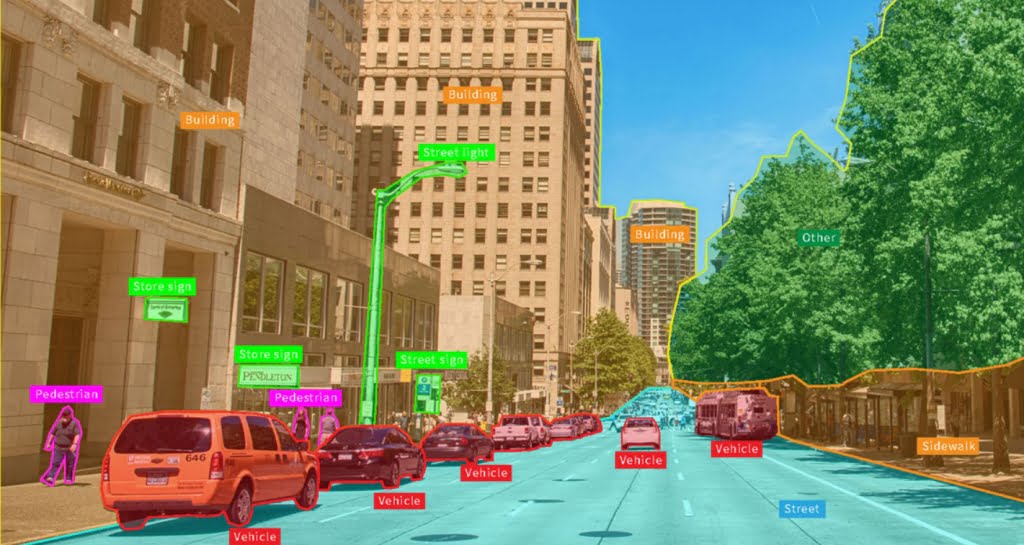

L’une des applications les plus populaires de l’apprentissage profond est la conduite autonome de véhicules. Les algorithmes d’apprentissage profond qui fonctionnent en coulisse peuvent reconnaître des objets sur la route, tels que :

-

Signalisation routière

-

Piétons

-

Feux de circulation

-

Voies de circulation

-

Autres véhicules

Par ailleurs, les systèmes de commande vocale modernes sont alimentés par des algorithmes intelligents d’apprentissage profond.

Le deep learning a pris beaucoup d’ampleur ces dernières années. Et, ce, grâce à des réalisations qui n’étaient pas possible auparavant.

Comment fonctionne le deep learning ?

Un programme d’apprentissage profond typique peut effectuer des classifications à partir d’images, de sons ou de textes. L’algorithme d’apprentissage profond analyse une grande collection de données d’entraînement avec une architecture de réseau neuronal multicouche.

Le Deep Learning a été théorisé en 1980. Ce n’est pas un nouveau concept. Grâce aux dernières avancées en matière de puissance de calcul, la théorie est devenue réalité.

L’apprentissage profond est un processus gourmand en ressources informatiques. Les algorithmes de Deep Learning ont besoin de beaucoup de données étiquetées pour bien fonctionner. Par exemple, pour entraîner un algorithme d’apprentissage profond à conduire une voiture, il doit analyser des millions d’images de la route.

De nos jours, les GPU ont des performances bien plus élevées que dans les années 1980. Ainsi, les développeurs peuvent écrire des algorithmes d’apprentissage profond efficaces dont le temps d’apprentissage est de quelques heures au lieu de semaines ou de mois.

Les algorithmes de deep learning utilisent généralement des réseaux neuronaux (ou réseaux neuronaux profonds). Voyons comment fonctionnent les réseaux neuronaux (Neural network).

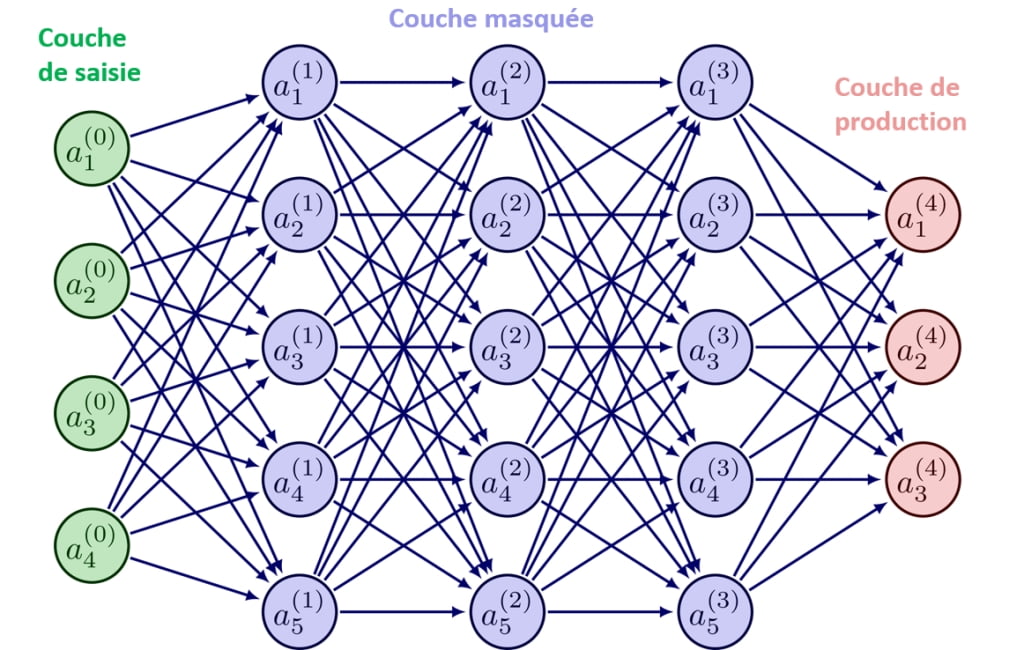

3. Réseau neuronal

Le réseau neuronal imite le comportement du cerveau humain en matière de reconnaissance des formes. Le réseau neuronal simule la façon dont les neurones biologiques communiquent entre eux dans le cerveau.

Comme vous l’avez appris précédemment, le réseau neuronal est un sous-ensemble de l’apprentissage profond. Un réseau neuronal constitue la base d’un algorithme d’apprentissage profond.

Comment fonctionne un réseau neuronal ?

Un réseau neuronal est formé par une couche d’entrée, une ou plusieurs couches cachées et une couche de sortie.

Les couches sont constituées de nœuds qui peuvent être traités comme des neurones artificiels. Tous les nœuds sont connectés à tous les nœuds de la couche suivante. Chaque nœud est également associé à un poids et à un seuil.

Si la sortie d’un nœud dépasse le seuil, il est activé et envoie des données à la couche suivante.

Ce processus rappelle l’activité d’apprentissage qui a lieu en permanence dans notre cerveau.

Lors de la formation d’un algorithme de deep learning, le développeur fait passer les données de formation par un réseau neuronal. L’algorithme apprend à classer les données d’apprentissage à l’aide des activations du réseau neuronal. La précision du modèle s’améliore progressivement.

Pour rester dans le cadre de notre exposé, nous n’allons pas nous attarder sur les mathématiques des réseaux neuronaux. Vous devriez maintenant avoir un niveau de compréhension de base du fonctionnement de l’apprentissage automatique, de l’apprentissage profond et des réseaux neuronaux.

Les sections suivantes vous permettront de découvrir d’autres sous-domaines pertinents de l’IA, à commencer par l’informatique cognitive.

4. L’informatique cognitive

L’informatique cognitive consiste à utiliser des modèles informatiques pour imiter le processus de pensée humain dans des situations incertaines.

Ce sous-domaine de l’IA vise à permettre aux ordinateurs de comprendre le langage naturel et de rendre possible la reconnaissance des objets. Les programmes imitent le comportement du cerveau humain.

L’informatique cognitive est un mélange d’autres sous-domaines de l’intelligence artificielle. Pour atteindre les objectifs de l’informatique cognitive, les technologies et les sous-domaines de l’IA suivants sont utilisés :

-

Réseaux neuronaux

-

Apprentissage automatique

-

Apprentissage profond

-

Traitement du langage naturel

-

Reconnaissance de la parole

-

Reconnaissance d’objets

-

Robotique

-

Etc.

Lorsque ces éléments sont combinés à des algorithmes intelligents d’auto-apprentissage, à la reconnaissance des formes et à une analyse appropriée des données, les bases de l’informatique cognitive sont posées !

L’informatique cognitive est utile dans un large éventail de secteurs, notamment l’évaluation des risques, la reconnaissance vocale, la détection des visages et bien d’autres encore.

Comment fonctionne l’informatique cognitive ?

Comme les autres sous-domaines de l’Intelligence artificielle, l’informatique cognitive utilise des algorithmes d’auto-apprentissage qui nécessitent une tonne de données structurées ou non structurées.

Les données sont transmises à un algorithme d’apprentissage automatique qui peut apprendre des modèles à partir des données. Ces systèmes cognitifs peuvent affiner le traitement des données et le processus d’identification des modèles.

Par exemple, vous pouvez entraîner à une IA à reconnaître des photos de chiens. Pour que ce type de système cognitif fonctionne, vous devez avoir des tonnes de photos de chiens. Plus le système voit d’images de chiens, plus il s’améliore dans leur reconnaissance.

Pour qu’un système cognitif atteigne les capacités décrites précédemment, il doit être :

-

Adaptatif et flexible pour pouvoir apprendre même lorsque l’information varie.

-

Interactifs afin que les utilisateurs puissent interagir avec les systèmes cognitifs pour définir leurs besoins lorsqu’ils changent. En outre, les systèmes doivent interagir avec d’autres systèmes, dispositifs et plateformes.

-

Itératif pour poser des questions et recueillir des données supplémentaires afin de donner un sens à un nouveau problème.

-

Historique pour conserver des informations sur des situations similaires dans le passé.

-

Contextuel pour comprendre le contexte du problème. Un système cognitif efficace comprend, identifie et exploite les données contextuelles. Il peut s’agir de tâches, d’objectifs, d’emplacements, de domaines, de syntaxes ou de quelque chose de semblable. Ces données peuvent provenir de plusieurs sources et être structurées ou non.

5. Traitement du langage naturel (NLP)

Le traitement du langage naturel (Natural Language Processing, ou NLP) est un sous-domaine populaire de l’intelligence artificielle. Le NLP permet à un ordinateur de traiter le texte et le langage parlé comme le font les humains. Cela permet une interaction en langage naturel entre un ordinateur et un humain.

Le NLP est une combinaison d’éléments suivants :

-

Linguistique informatique

-

Modèles statistiques

-

Modèles d’apprentissage automatique

-

Modèles d’apprentissage profond

Lorsqu’elles sont combinées, ces technologies permettent aux ordinateurs de comprendre le sens complet du texte ou de la langue parlée. Le système NLP est également capable de détecter l’intention et le sentiment du locuteur !

Le NLP est particulièrement utile et couramment utilisé dans :

- Les traductions

- La réponse aux commandes vocales

- Le résumer rapide d’énorme volume de textes

Il y a de fortes chances que vous ayez déjà interagi avec un système NLP dans le passé. Par exemple, tous les programmes de synthèse vocale utilisent la PNL en arrière-plan.

De même, de nombreux sites Web disposent de chatbots automatisés. Ceux-ci sont alimentés par des algorithmes NLP qui visent à comprendre l’intention du client.

Comment fonctionne le traitement du langage naturel ?

Le langage humain est ambigu à bien des égards. Pour prédire avec précision l’intention d’un texte ou d’un langage parlé, il faut comprendre :

-

Le sarcasme

-

Les idiomes

-

Métaphores

-

Les exceptions grammaticales

-

Les exceptions d’usage

-

Variations de la structure de la phrase

-

Homonymes

-

Homophones

Eh bien d’autres encore.

Pour qu’un logiciel axé sur le langage naturel soit performant, il doit être capable de comprendre chacune de ces irrégularités.

Voici des approches populaires de NLP qui divisent le texte en parties logiques pour aider le système à mieux le comprendre.

- La reconnaissance vocale.

Cette stratégie convertit la voix en texte. Tout logiciel qui répond à des questions orales ou suit des commandes vocales doit utiliser cette stratégie. Il s’agit d’un défi de taille, car les humains parlent de manière irrégulière.

Certains parlent vite, d’autres marquent des points, d’autres encore accentuent différemment les mots. De plus, les gens ont des accents différents et utilisent des termes argotiques ou une grammaire incorrecte.

- Le marquage grammatical.

Cette stratégie détermine le type d’un mot en fonction du contexte. Par exemple, le mot « accusé » est un verbe dans le contexte de « François a accusé Frédéric ». En revanche, le mot « accusé » est un nom dans le contexte de « Les policiers ont fait entrer l’accusé dans le tribunal ».

- Désambiguïsation du sens des mots.

Il s’agit d’une approche d’analyse sémantique pour aider les mots ayant un double sens. Elle détermine le mot qui a le plus de sens dans le contexte. Par exemple, « a passé son examen » signifie « réussir son examen ». Mais « a passé le ballon » veut dire « a donné le ballon ».

- Reconnaissance des entités nominales.

Cette technique permet d’extraire du texte des mots et des phrases utiles. Par exemple, elle peut déterminer que « Paris » est un endroit ou que « Fred » est le nom d’un homme.

- Reconnaissance de coréférence.

La reconnaissance de coréférence est utilisée pour comprendre quand deux mots signifient la même chose. L’exemple le plus courant consiste à déterminer à quelle personne un pronom fait référence. Par exemple, « Valérie est ma femme. Elle m’a préparé le petit-déjeuner ». Dans cette phrase, la reconnaissance de coréférence est utilisée pour déterminer que le mot « Elle » fait référence à « Valérie ».

- Analyse des sentiments.

Il s’agit d’une approche visant à comprendre le sarcasme, les émotions, la suspicion, la confusion et les attitudes à partir du texte.

- Génération de langage naturel.

Il s’agit du processus inverse de la synthèse vocale. La génération de langage naturel prend des informations structurées et les convertit en langage humain.

6. Visualisation informatique (Computer vision)

La visio-informatique est un sous-domaine clé de l’IA qui permet aux ordinateurs d’extraire des informations à partir d’images, de vidéos et d’autres types d’entrées visuelles.

Plus important encore, les systèmes de vision par ordinateur peuvent prendre des mesures ou proposer des recommandations sur la base des informations extraites.

Par exemple, les voitures à conduite autonome utilisent la technologie de visualisation par ordinateur pour se frayer un chemin.

Pour simplifier, l’IA fait réfléchir les ordinateurs et la vision par ordinateur leur permet de voir et d’observer.

Comme les autres sous-domaines de l’intelligence artificielle, la visualisation par ordinateur imite le comportement du cerveau humain qui observe les choses. En outre, pour former la vision par ordinateur, il faut beaucoup de données.

Pour construire une bonne visualisation par ordinateur, vous devez fournir à l’algorithme de visualisation par ordinateur un grand nombre de données. L’algorithme effectue ensuite une analyse rigoureuse des données jusqu’à ce qu’il commence à reconnaître des objets à partir d’images.

Par exemple, pour entraîner la reconnaissance de feu de circulation, le système a besoin de milliers d’images de feu de circulation.

En outre, il doit apprendre à faire la différence entre un feu de signalisation et un poteau lumineux, entre autres. Par conséquent, le système doit également ingérer un grand nombre d’images d’objets liés aux feux de circulation.

Comment fonctionne la vision par ordinateur ?

Pour construire un programme de visualisation par ordinateur efficace, deux technologies principales sont utilisées :

- Le Deep Learning

- Réseaux neuronaux convolutifs (CNN)

Les algorithmes d’apprentissage profond permettent à l’ordinateur d’apprendre à connaître le contexte d’une image ou d’une vidéo. Une fois que le système a digéré suffisamment de données, il peut les voir et commencer à distinguer les images les unes des autres.

La clé est qu’une fois que le système est opérationnel, il n’est pas nécessaire qu’un humain programme les règles de reconnaissance des images. Au lieu de cela, c’est le système d’apprentissage automatique qui apprend tout seul.

Pour apprendre à partir des images, un réseau neuronal convolutif (CNN) est utilisé.

Le CNN aide le modèle d’apprentissage profond à « voir » les images. Il fonctionne en divisant une image en pixels étiquetés d’une manière particulière. L’algorithme utilise ensuite les pixels étiquetés pour prédire ce qu’il voit dans l’image.

Le CNN fonctionne en appliquant une opération mathématique appelée convolution aux données des pixels de manière répétée. Une fois la convolution appliquée, le programme vérifie la précision de ses prédictions.

Lorsqu’elles sont suffisamment répétées, les prédictions commencent à devenir précises et le programme peut ainsi voir les objets comme nous, les humains, le faisons.

Pourquoi l’intelligence artificielle est-elle importante pour nous ?

Grâce à l’IA, les humains sont capables d’automatiser le processus d’apprentissage et d’analyse des données.

Lorsqu’il y a beaucoup de données, il serait impossible pour un humain de les analyser toutes et d’en tirer des informations pertinentes. C’est là que l’intelligence artificielle intervient.

L’IA permet aux entreprises et aux chercheurs de tirer des renseignements précieux des données.

Comme l’IA fonctionne sur un ordinateur, il n’y a pratiquement aucune fatigue. Plus important encore, le processus de découverte des données est fiable.

Même si l’IA est révolutionnaire dans un certain sens, nous avons toujours besoin d’humains pour poser les bons types de questions. De plus, nous avons besoin d’humains pour coder les programmes d’IA afin de découvrir les réponses à nos questions.

L’IA est généralement utilisée pour ajouter de l’intelligence à des produits ou des solutions existants. Il est rare qu’une solution soit entièrement basée sur l’IA.

Par exemple, la nouvelle génération de produits Apple utilise Siri, qui est une fonction de contrôle vocal basée sur l’IA. Sans Siri, les produits Apple seraient toujours plus qu’impressionnants, mais Siri rend l’utilisation des produits encore plus simple.

FOIRE AUX QUESTIONS

Enfin, jetons un coup d’œil à certaines questions courantes liées à l’intelligence artificielle.

Puis-je créer de l’intelligence artificielle sans savoir coder ?

Non, l’IA est avant tout une question de codage.

Pour construire un programme d’IA, il faut qu’il y ait du code quelque part en arrière-plan.

Lorsque j’ai entendu parler de l’IA pour la première fois, quelqu’un m’a dit : « C’est une sorte de magie où les ordinateurs apprennent des choses sans avoir besoin de coder ».

C’est en partie vrai, car les programmes d’IA imitent effectivement le processus d’apprentissage humain. Un programme d’IA peut prendre des décisions semblables à celles des humains, au lieu de coder les règles en dur dans le programme.

Mais, pour créer un programme d’IA, un développeur de logiciels doit écrire du code comme dans tout autre programme informatique.

Quelle est la différence entre l’intelligence artificielle et le machine learning ?

Le machine learning ou ML est un sous-ensemble de l’intelligence artificielle. Le domaine du machine learning est donc régi par le concept d’IA. Cela signifie que toute application du machine learning est également une solution d’IA.

Vous verrez souvent les termes « machine learning » et « intelligence artificielle » utilisés de manière interchangeable.

Notez que l’apprentissage automatique est un sous-domaine de l’IA, que l’apprentissage profond est un sous-domaine de l’apprentissage automatique et que les réseaux neuronaux sont un sous-domaine de l’apprentissage profond.

L’IA dominera-t-elle le monde des humains ?

C’est impossible à dire.

Si les capacités de l’IA dépassent celles du cerveau humain, il est difficile de dire ce qui se passera.

Le scénario le plus dystopique est que l’IA réalise que les humains ne sont que nuisibles et qu’elle décide de se débarrasser de nous.

Mais, il est tout aussi probable que l’IA considére les humains comme des amis. Dans ce cas, les systèmes d’IA feront tout pour nous garder en vie et nous faire sentir aussi à l’aise que possible.

Il est également possible que le développement rapide de l’IA ralentisse ou se heurte à un mur, de sorte qu’une IA consciente ne sera jamais créée.

Heureusement, nous avons encore le contrôle des choses. En fin de compte, ce sont les humains qui décident où ils veulent apporter les potentialités de l’IA. Espérons que nous ne franchirons jamais le point de non-retour !

Au rythme actuel du développement, des choses étonnantes et incroyables vont se produire dans les années à venir, c’est certain !

Quand l’IA a-t-elle été inventée ?

Le concept d’IA n’est pas nouveau. Les premières théories de solutions basées sur l’IA ont vu le jour en 1940.

L’IA est restée longtemps à l’état de concept, car la puissance de calcul n’était pas suffisante pour la concrétiser.

Aujourd’hui, l’IA se développe plus rapidement que jamais. On a l’impression que de nouvelles solutions apparaissent chaque jour.

Pourquoi semble-t-il que toutes les entreprises utilisent l’IA de nos jours ?

L’utilisation de l’intelligence artificielle n’est pas aussi difficile ou magique qu’il n’y paraît. N’oubliez pas que l’IA peut être quelque chose d’enfantin, comme un modèle de régression linéaire permettant de prédire la distance de saut des kangourous. Dans l’ensemble, l’IA n’est que des mathématiques, des probabilités et des analyses de données.

Selon l’entreprise, l’utilisation de l’IA peut rationaliser certains processus et contribuer à réduire les coûts. Le plus important, c’est que l’ajout d’un petit élément d’IA à la logique de l’entreprise permet de faire un gros titre très médiatique.

Comment essayer l’IA ?

Pour ressentir la puissance de l’IA, il vous suffit d’ouvrir le système de commande vocale de votre appareil mobile et de lui donner quelques instructions.

Le système de conversion de la parole en texte qui alimente les systèmes de commande vocale est un exemple courant d’utilisation de l’IA.

Les chatbots automatisés constituent un autre cas d’utilisation très courant de l’IA. Les sociétés de logiciels, en particulier, ont tendance à souvent utiliser les chatbots d’IA.

Lorsque vous entrez sur le site Web d’une société SaaS, il y a de fortes chances qu’une boîte de dialogue apparaisse. Lorsque vous posez une question, le service de chatbot IA utilise le NLP pour déterminer l’intention de votre message et trouver une réponse.

Serait-il difficile d’apprendre l’intelligence artificielle ?

Apprendre l’IA est plutôt simple. Cela prend du temps et nécessite beaucoup de pratique.

Pour apprendre l’IA, vous devez apprendre deux choses :

1. La programmation. Un langage typique utilisé dans les programmes d’IA est le Python, qui est un langage convivial pour les débutants.

2. Les mathématiques. Vous devrez également connaître un peu d’algèbre linéaire et de probabilités pour construire des programmes d’IA.

Si l’IA vous intéresse, vous pouvez commencer par découvrir comment coder en Python. L’apprentissage du codage ou de l’IA ne se fait pas du jour au lendemain. Vous devez passer des mois avant d’être capable de construire quelque chose de significatif :).

Récapitulatif

Nous avons appris aujourd’hui ce qu’est l’intelligence artificielle.

Pour résumer, l’intelligence artificielle utilise des ordinateurs pour imiter le processus d’intelligence humaine. Bien que l’IA ne soit pas un nouveau concept, les derniers développements en matière de puissance informatique ont transformé la théorie en réalité.

Dans les coulisses, l’IA n’est rien d’autre que de l’algèbre linéaire, des probabilités et du code de programme.

Aujourd’hui, l’IA est utilisée dans de nombreuses applications dans de nombreux secteurs. En général, l’IA constitue un excellent complément à un produit existant. Par exemple, Apple utilise Siri, qui est un système de commande vocale basé sur l’IA. Ce système rend l’utilisation des produits Apple encore plus efficace.

En tant que concept général, l’IA comporte un grand nombre de sous-domaines. Il s’agit notamment de :

-

L’apprentissage automatique ou Machine Learning

-

L’apprentissage profond ou Deep Learning

-

Réseaux neuronaux ou Neural Networks

-

L’informatique cognitive ou Cognitive computing

-

Traitement du langage naturel ou Natural language processing (NLP)

-

Vision par ordinateur ou Computer vision

- DeepSeek : comment résoudre l’erreur « The server is busy please try again later » - 1 février 2025

- Télécharger des Vidéos YouTube : Votre Guide Complet - 27 février 2024

- Mac, lequel choisir ? - 17 février 2024